Apple、児童ポルノスキャン機能の開発を断念した理由を説明

Appleが、2021年8月に発表したもののプライバシー侵害や国家による弾圧への懸念から批判が集中した性的虐待画像(CSAM:Child Sexual Abuse Material)の検出を断念した理由を詳細に説明しています。脆弱性の悪用や、監視に拡大される懸念が開発断念の理由だったとのことです。

■3行で分かる、この記事のポイント

1. Appleが、子どもの性的虐待画像スキャン機能の開発断念理由を説明。

2. 脆弱性を悪用される可能性や、一斉監視社会につながる懸念があったとのこと。

3. 子どもを性的虐待から保護する他の機能は提供されており、iOS17で進化する。

2021年8月に発表後、物議醸したCSAMスキャン

Appleは2021年8月に、児童への性的虐待画像(CSAM:Child Sexual Abuse Material)を機械学習技術によってデバイス上で検出し通報する機能をセキュリティ研究者や市民団体、そしてApple従業員からも疑問の声があがりました。

Appleへの批判には、本来の目的である児童の保護ではなく、国民による批判を取り締まる政府による弾圧などに拡大解釈されるのではないか、との懸念も含まれていました。

Appleはプライバシーを保護して運用される同機能の安全性を強調しましたが、2022年12月には導入を断念したことを公式に認めています。

犯罪者による悪用、一斉監視の扉を開く懸念から開発を断念

Appleは、児童保護のために活動する団体Heat Initiativeからティム・クック最高経営責任者(CEO)宛のCSAM画像の検出と通報を求める書簡に対して、Appleのユーザープライバシーと児童安全部門の責任者であるエリック・ノインシュワンダー氏からの回答を米メディアWIREDに公開しました。

同団体はWebサイトで、AppleがiCloud上にCSAM画像や動画が保存されることを容認していると批判し、CSAM画像や動画を検出し、通報して削除するよう要求しています。

Appleは、CSAMスキャンについてプライバシーやセキュリティの研究者、デジタル権利擁護団体、子供の安全擁護団体と協議した結果、プライバシー保護に注力して構築したシステムであってもCSAMスキャン機能の開発を続けることはできない、との結論に達したと説明しています。

その理由として、すべてのユーザーのデータをスキャンすることは、犯罪者がシステムの脆弱性を見つけて悪用する可能性につながるほか、一斉監視の扉を開き、コンテンツの種類を問わず、暗号化された他のメッセージシステムを検索したいという新たな欲求を生み出す可能性がある、ともAppleは説明しています。

メッセージの画像スキャン義務付ける英法案にAppleがノー

イギリスでは、暗号化されたメッセージプラットフォームを提供する事業者に対して、送受信される画像のスキャンを義務付ける法案が審議されています。

Appleは、同法案が成立するならイギリスでiMessageやFaceTimeのサービス提供を終了すると反対を表明しています。

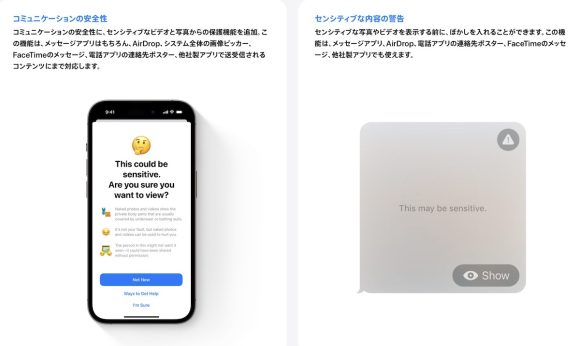

iOS17では「コミュニケーションの安全性」も進化

Appleが2021年に発表した、子供を性的虐待から保護するための機能は、CSAM画像の検出だけではありません。

「コミュニケーションの安全性」として、性的な画像の送受信時に画像にぼかしを入れて警告メッセージを表示する機能と、Safari検索、Siri、Spotlight検索で児童保護のための情報を得られやすくする機能が、日本でも提供されています。

iOS17では、センシティブな写真とビデオの検出と警告機能が、AirDropで受信する前のサムネイルや、システム全体の画像ピッカーやサードパーティー製アプリにも提供されます。

「コミュニケーションの安全性」機能は、「設定」アプリの「スクリーンタイム」から設定できます。

Source:WIRED, Heat Initiative via MacRumors, 9to5Mac, Apple

Photo:danesdrone/YouTube

(hato)