Apple、子供がヌード写真送受信で警告する機能を日本でも導入へ

Appleは、子供が性的な画像を送受信しようとすると警告する児童保護機能を日本でも数週間以内に提供することを明らかにした、と日本経済新聞などが報じています。検出はデバイス上の人工知能(AI)が行い、Appleが写真やメッセージの内容を見ることはありません。

ヌード写真の送受信しようとすると自動でボカシ

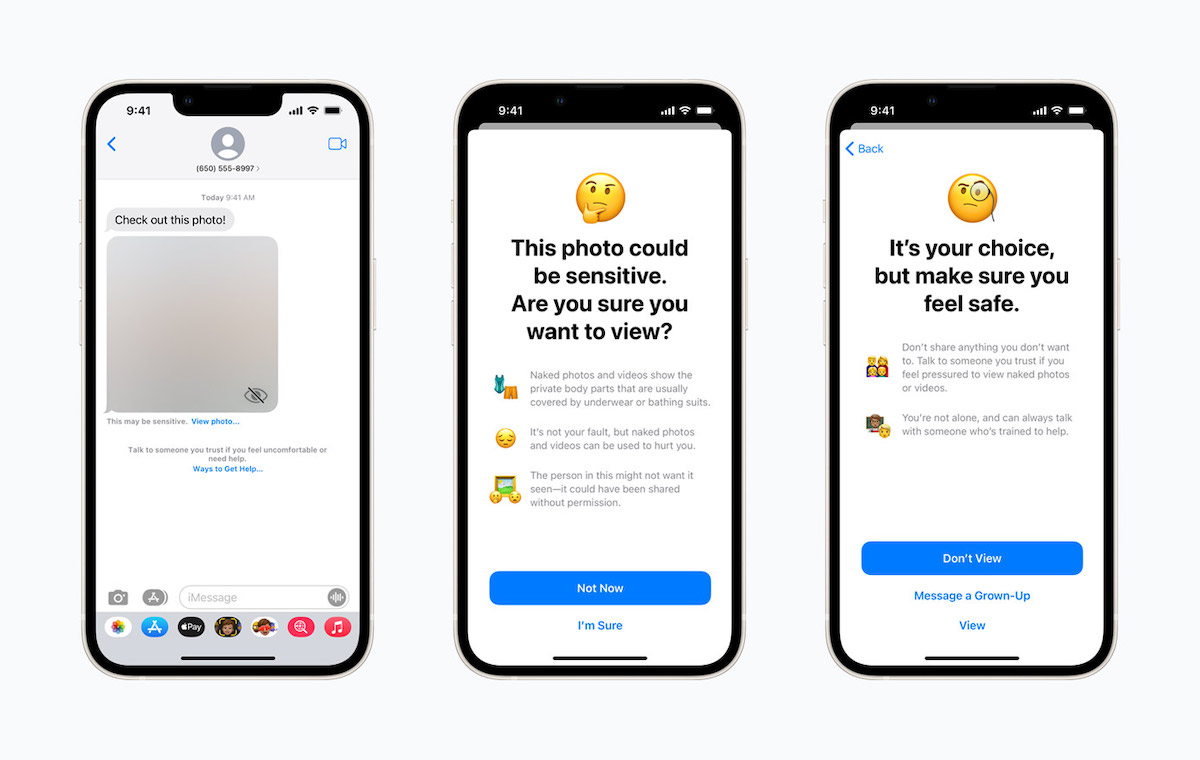

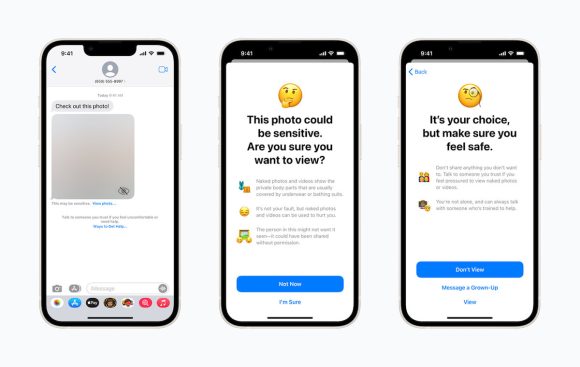

Appleが導入する児童保護機能は、iPhoneなどの「メッセージ」アプリで性的な画像を受信した場合や送信しようとしているとデバイスが判断した場合、画像にボカシが入り、注意を促すメッセージが表示され、コンテンツのブロックや信頼できる大人への相談といった選択肢が表示されます。

子供がヌード画像を送受信する選択をした場合、自身の安全を確認するよう促すメッセージが表示されます。

2021年12月に米国で提供開始

英語圏では「Communication Safety(コミュニケーションの安全性)」として提供されている同機能は2021年12月にアメリカで提供が開始され、2022年4月にはイギリスとカナダに拡大し、現在は9カ国で利用可能となっています。

数週間以内に、日本、韓国、ブラジルなど6カ国でも提供が開始される予定です。

ファミリー共有での設定が必要

「Communication Safety」を利用するには、iCloudのファミリー共有機能で子供として登録されたユーザーのペアレンタルコントロールを有効にしたうえで、不適切な写真を確認するチェックをオンにする設定が必要です。

ヌード画像の検出はデバイス上のAIによって行われるため、送受信される画像やメッセージの内容をAppleが見ることはなく、ヌード画像の検出が行われたことをAppleが把握することもありません。

物議醸したCSAM検出とは別物

「Communication Safety」機能は、デバイスに保存された画像をデバイスが自動スキャンし、データベースに登録された児童への性的虐待(CSAM:Child Sexual Abuse Material)画像を検出する機能とは別物です。

なお、CSAM画像の検出機能は、プライバシー保護の問題や、政治的な検閲や思想弾圧に転用される危険性が指摘され、Appleは導入の延期を発表しています。

児童の性被害防ぐためには取り組みの拡大に期待

「Communication Safety」機能は、児童が性的搾取の被害者になるケースがアメリカで社会問題化していることを受けて開発されたと日本経済新聞は報じています。

日本でも、スマートフォンや各種SNSの普及に伴い、子供が性犯罪の被害者になる事件がたびたび報じられています。

娘を持つ父親である筆者としては、子供が性犯罪被害に遭うのを防ぐためには、Appleの「メッセージ」アプリだけでなく、各種SNSサービスにおいても、希望すれば同様の機能を利用できるようになって欲しいと思います。

Source:日本経済新聞, 共同通信, Apple (1), (2)

(hato)