AIアシスタントの賢さを比較!Googleがトップ、Siriは残念な結果に

AIアシスタントがユーザーの質問を理解し、正確に回答する能力を比較した調査結果が発表されました。Google Assistantが高い成績を残し、AmazonのAlexaが大きく成績を伸ばす一方、Siriは質問を理解して回答した割合が低く、誤答率が高い結果となりました。

約5,000の質問でAIアシスタントの能力を比較!

各社のAIアシスタントが、どの程度質問に的確に答えられるを比較した調査結果をアメリカの調査会社Stone Templeが発表しました。

調査は、以下の5タイプのAIアシスタントに4,942の質問を投げかけて、回答を比較しています。

- Alexa (Amazon)

- Cortana (Microsoft) 搭載のスマートスピーカー「Invoke」

- Google Assistant (Google) Google Home版

- Google Assistant (Google) スマートフォン版

- Siri (Apple)

比較にあたっては、「言葉での回答があったか」「データベースから回答しているか」「Wikipediaなど外部ソースから回答しているか」「AIアシスタントが質問を理解できなかった頻度」「回答が間違っていた回数」といった指標で評価しています。

なお、各社のAIアシスタントには、レストランの予約、商品の発注といった機能もありますが、調査の対象となっていません。

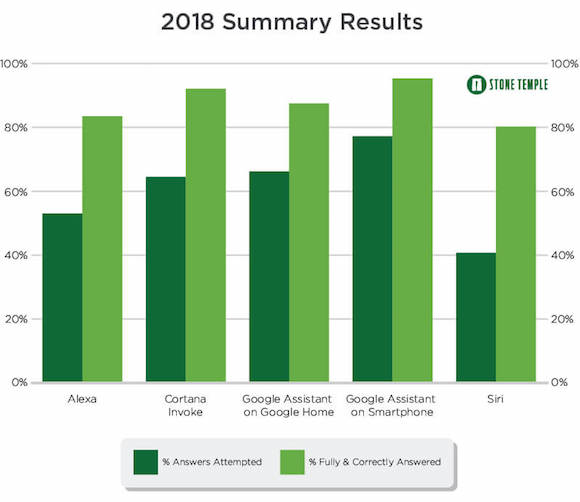

質問に回答しようとする割合、Siriは最下位

質問を理解し、回答しようとした割合である「回答試行率」(濃い緑)と、そのうち一発で質問に十分な回答をした割合を示す「完全回答率」(薄い緑)を示したのが以下のグラフです。

なお、回答試行率には、「まだ勉強中です」「すみません、よく分かりません」といった回答はカウントされません。

Google Assistantのスマートフォン版が回答試行率、完全回答率ともにトップに立っています。

一方、Siriは回答試行率が約40%と、他のAIアシスタントと比べて低くなっています。

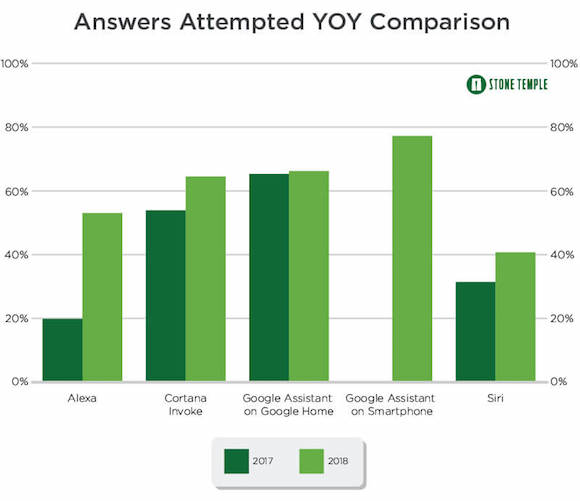

回答試行率、伸び幅はAlexaがトップ

回答試行率を2017年(濃い緑)と2018年(明るい緑)で比較したのが以下のグラフです。Google Assistantのスマートフォン版は2017年には公開されていなかったため、データがありません。

2017年から2018年で、Alexaが19.8%から53.0%へと大きく伸びているのが目立ちます。Cortana Invokeも、53.9%から64.5%へと伸びています。

Siriも、31.4%から40.7%へと上昇していますが、伸び幅が小さいため、Alexaに追い越されてしまっています。

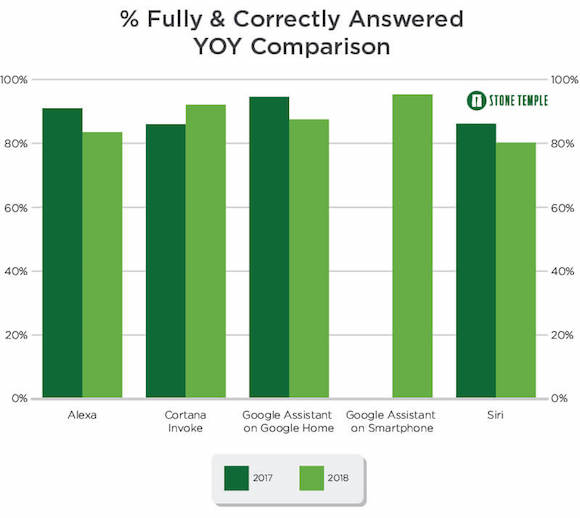

回答できれば8割以上は正確に回答

回答できた質問のうち、回答の正確さを示す完全回答率を2017年と2018年で比較すると、Cortana Invokeだけが86.0%から92.1%へと成績を伸ばしています。

Google Assistantのスマートフォン版が、質問に対して最も正確な回答を提供しており、Cortanaが続いています。

Alexaは2017年から2018年にかけて完全回答率が低下していますが、回答試行率が約2.7倍と大きく伸びています。

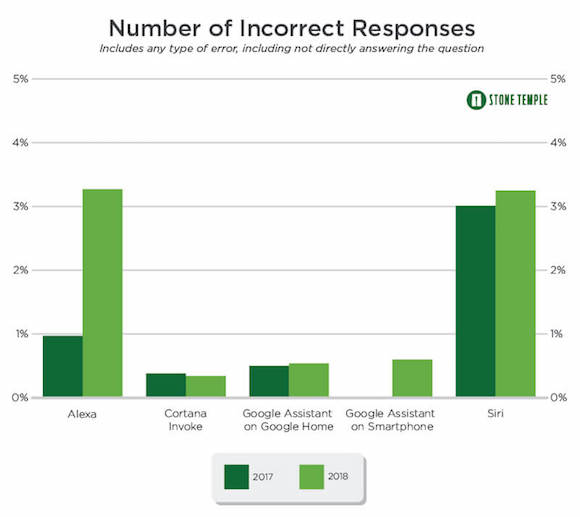

誤答率が高かったのはAlexaとSiri

それぞれのAIアシスタントが間違った回答をした、誤答率を2017年と2018年で比較したのが以下のグラフです。

2018年の誤答率が最も高かったのはAlexaで、Siriが僅差で続いています。

Stone Templeによると、AlexaとSiriで誤答が多かったのは、文の構成が曖昧でわかりにくい質問で、AlexaとSiriが間違った回答をした3分の1以上が当てはまったそうです。

なお、誤答の内容を分析した結果、誤答は全てユーザーが「これは間違った答えだ」と明確に認識可能なものでした。

「1インチは何センチ?」という質問に「2.7センチです(正しくは2.54センチ)」というような、ユーザーに間違った情報を信じ込ませるようなものはありませんでした。

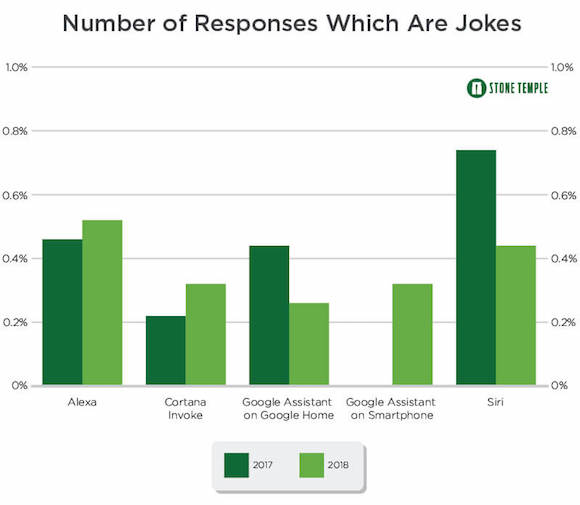

ジョークで回答する割合、SiriがAlexaに抜かれる

質問にジョークで回答した割合を2017年と2018年で比較したのが以下のグラフです。

2017年はSiriがトップでしたが、2018年はAlexaに抜かれています。

タイムリーなネタも織り交ぜてくるSiriのジョークは、iPhone Maniaでもよくネタにしています。

スマートスピーカーで重要になるAIアシスタント

2018年のテクノロジー業界で最も成長が期待される市場であるスマートスピーカーは、AIアシスタントが正確にユーザーの希望に応える能力が特に重要です。

Amazon、Googleが先行するスマートスピーカー市場に乗り遅れたAppleのHomePodは、音質の良い高級スピーカー路線を打ち出していますが、Siriの能力が低いことが問題、とも指摘されています。

Amazonは最近、Alexaに過去の会話を記憶するなどの大型アップデートを追加すると発表しています。

Source:Stone Temple via PhoneArena

(hato)