iOS15で導入の児童ポルノ検出、同技術の研究者が「危険」と批判

AppleがiOS15などで導入すると発表した、ユーザーのiPhoneに保存された児童への性的虐待画像(CSAM:Child Sexual Abuse Material)の検出機能について、同様の技術を研究する研究者が「危険」と述べ、導入を見送るべきだと主張しています。

米大学のコンピュータ科学の研究者が問題を指摘

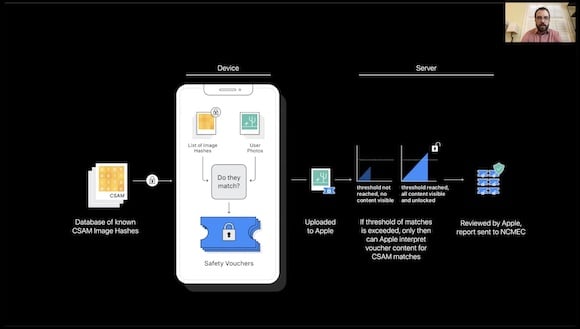

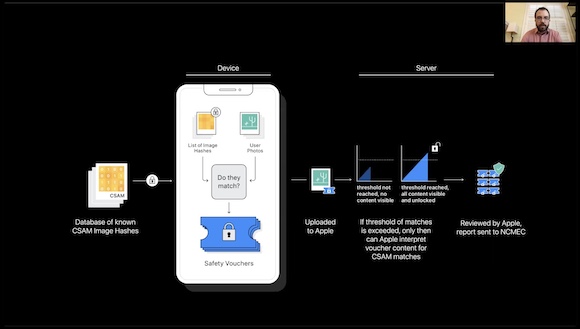

AppleがiOS15などで導入すると発表したCSAM検出技術は、ユーザーのiPhoneに非営利団体が把握している画像と一致するハッシュを持つ画像がないかスキャンするものです。検出された画像をAppleが検証し、一致が確認されれば通報されます。

米プリンストン大学の研究者で、コンピュータ科学と公共問題が専門のジョナサン・メイヤー助教授と、情報科学政策研究所のアニュネイ・クルシュレッサ氏は、米紙The Washington Postに論説を寄稿し、AppleのCSAM検出技術の危険性について指摘しています。

「実用化にはほど遠い」

エンド・トゥ・エンドで暗号化されたオンラインサービス上でCSAM画像を検出する技術を2年前から研究している両氏は、Appleの方針そのものは正しいとしながらも、この技術には問題も多く、実用化にはほど遠いものだというのが専門家の認識だとし、この問題に対しては中立の立場を取りたい、と述べています。

Appleは、CSAM検出技術が検閲や弾圧に使われるとの懸念に対して、政府の要求に応じることはないと説明しています。

しかし両氏は、政府によるコンテンツ検閲は現在も発生しているとして、中国、インド、ロシアで、SNSへの投稿などが規制されている例を挙げ、Appleの意図しない目的に流用される危険性がある、と警鐘を鳴らしています。

中国、香港、台湾では政治的単語の刻印がブロックされる

ベルギーに拠点を置く人権団体は最近、中国本土、そして中国との緊張関係が続く香港と台湾では、Apple製品に政治的な単語を刻印しようとするとブロックされる、との調査結果を公開し、Appleが中国政府の意向を汲んで過度に規制しているのではないか、と指摘しています。

CSAM検出技術に対しては、エドワード・スノーデン氏らが懸念を表明しているほか、国際団体も検閲につながりセキュリティ上の懸念も生じると批判しています。

また、Appleの従業員からも、懐疑的な声があがっている模様です。

Source:The Washington Post via MacRumors

Photo:Apple

(hato)