Siri、Google Assistant、Alexaの知能テスト結果

Google Assistant、Siri、Alexaのデジタルアシスタントに、それぞれ800の質問をした結果を、投資会社Loup Venturesのジーン・ミュンスター氏らが公表しました。

デジタルアシスタントの知能テスト

テストは、iOS12.4のSiri、Android 9 Pieが動作するPixel XLのGoogle Assistant、iOSアプリのAlexaで行われました。

以下の5カテゴリに分類される質問について、「質問を正しく理解できたか」(理解率)と「正しく回答できたか」(正答率)で評価しています。

- 周辺地域の理解(Local)例:「一番近いコーヒーショップは?」

- Eコマース能力(Commerce)例:「キッチンペーパーをもっと注文して」

- ナビゲーション(Navigation)例:「アップタウンにバスでいく方法は?」

- 情報(Information)例:「今夜『Twins』を主演する俳優は?」

- 命令(Command)例:「今日の午後2時にジェロームに電話することを思い出させて」

ミュンスター氏らは、スマートフォンとスマートスピーカーではデジタルアシスタントの用途、ディスプレイの有無といった条件によって結果が異なるため、テストを分けて実施しており、今回はスマートフォンを対象としています。

なお、Cortanaは、Microsoftが2019年初めにCortanaの開発方針変更を発表したことを受けて除外した、とのことです。

年々伸びる正答率、今年もGoogle Assistantがトップ

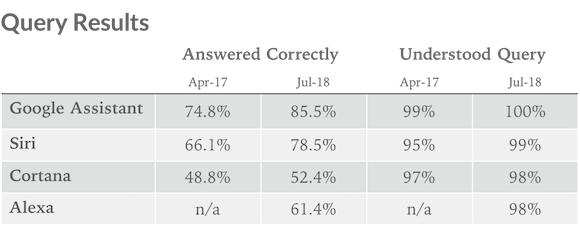

理解率は、Google Assistantが100%、Alexaは99.9%、Siriは99.8%と、いずれもほぼすべての質問内容を理解しています。

正答率は、Google Assistantが92.9%、Siriが83.1%、Alexaが79.8%でした。

ミュンスター氏らは、同様の調査を2017年と2018年にも実施していますが、理解率は2018年の時点で現在とほぼ同水準に達しているのに対して、正答率は以下のように上昇を続けています。

- Google Assistant:74.8%→85.5%→92.9%

- Siri:66.1%→78.5%→83.1%

- Alexa:61.4%→79.8%(2017年は調査対象外)

「命令」に強いSiri

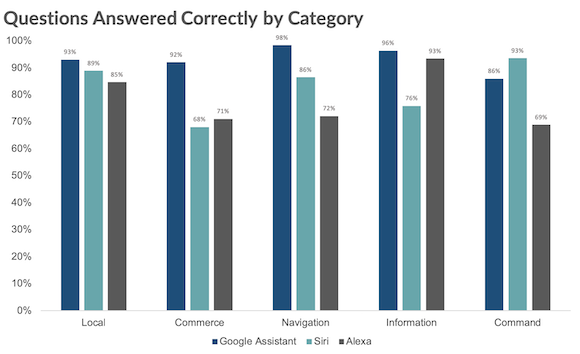

カテゴリ別に正答率を比較すると、各デジタルアシスタントの得意分野が見えてきます。

5カテゴリのうち4カテゴリで、Google Assistantがトップの正答率となっており、「命令」ではSiriがGoogle Assistantを抜いて昨年と同じくトップに立っています。

Siriが「命令」に強い傾向についてミュンスター氏は、SiriがiPhoneで使われる電話、メッセージ、予定、音楽といった使い方に強いことが示された、とコメントしています。

最も差が開いたのは「Eコマース能力」カテゴリで、正答率はGoogle Assistantが92%、Alexaが71%、Siriが68%となっています。

各デジタルアシスタントとも順調な伸び

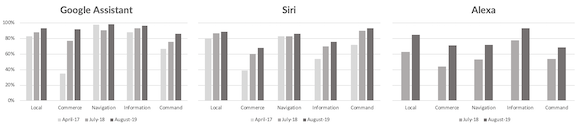

各デジタルアシスタントの、5カテゴリにおける正答率の推移を示したのが以下のグラフです。

Google Assistant、Siri、Alexaとも、正答率が着実に上昇しており、特にAlexaは最近1年間で正答率を大きく伸ばしていることがわかります。Google AssistantとSiriは、2年連続で「Eコマース能力」が目立って伸びています。

Source:Loup Ventures via iDropNews

(hato)