Appleは、児童性的虐待コンテンツ(CSAM)対策と児童虐待防止を目的とした、iCloudとiMessage上の2つの新機能の導入を発表しましたが、多くのユーザーから「プライバシーの侵害につながらないか」と危惧する声が上がっています。Appleは機能の導入を延期することを明らかにしましたが、完全に白紙に戻すべきとの意見が上がっています。

2つの機能の同時発表が誤解につながった?

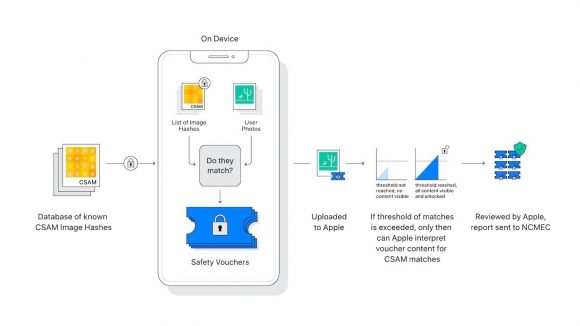

AppleはiOS15において、iCloud写真ライブラリのスキャンと、iMessageのメッセージのスキャンの2つの新機能を導入すると発表しました。

これら2つの機能はまったく異なる仕組みとなっていますが、同時に発表されてしまったことにより誤解を招いた、とApple役員のクレイグ・フェデリギ氏はコメントしています。

プライバシーの重要性を訴える電子フロンティア財団(EFF)は、AppleのCSAM対策機能でどれだけプライバシーとセキュリティが保たれるとしても、バックドアの設置に他ならない、と導入に強い反対の意を表明していました。

機能導入を白紙に戻すよう要求

多くのユーザーからの憂慮を受け、Appleは現地時間9月2日、児童虐待防止を目的としたスキャン機能の導入計画をいったん延期すると発表しました。

これを受け、EFFは「Appleが人々の声を聞くようになったのは素晴らしい」と称賛しつつも、「暗号化にバックドアを設置するような計画は完全に取りやめるべき」と、機能導入を白紙に戻すよう要求しています。

EFFは、サービスのスキャン機能の導入中止をAppleに求める署名活動も行っており、現在までに5万人以上の署名が集まった、と発表しています。

Source:EFF via AppleInsider

(lexi)